莫拉维克悖论:AI能拿奥数金牌,却摆弄不了一支钢笔

AI已能在奥数竞赛中夺金、编程超越99%人类,却连拿起铅笔都做不到。这背后隐藏着关于智能、进化与意识本质的深刻秘密。

|  |  |  |

2025年,AI推理模型在国际数学奥林匹克竞赛中拿到了金牌级水平。同一年,AI在编程竞赛中超越了99%以上的人类选手,跻身全球前两百名。

但是,如果你让这个能解最难数学题的AI拿起一支铅笔,把答案写在纸上——它做不到。它甚至没法自己翻开试卷。

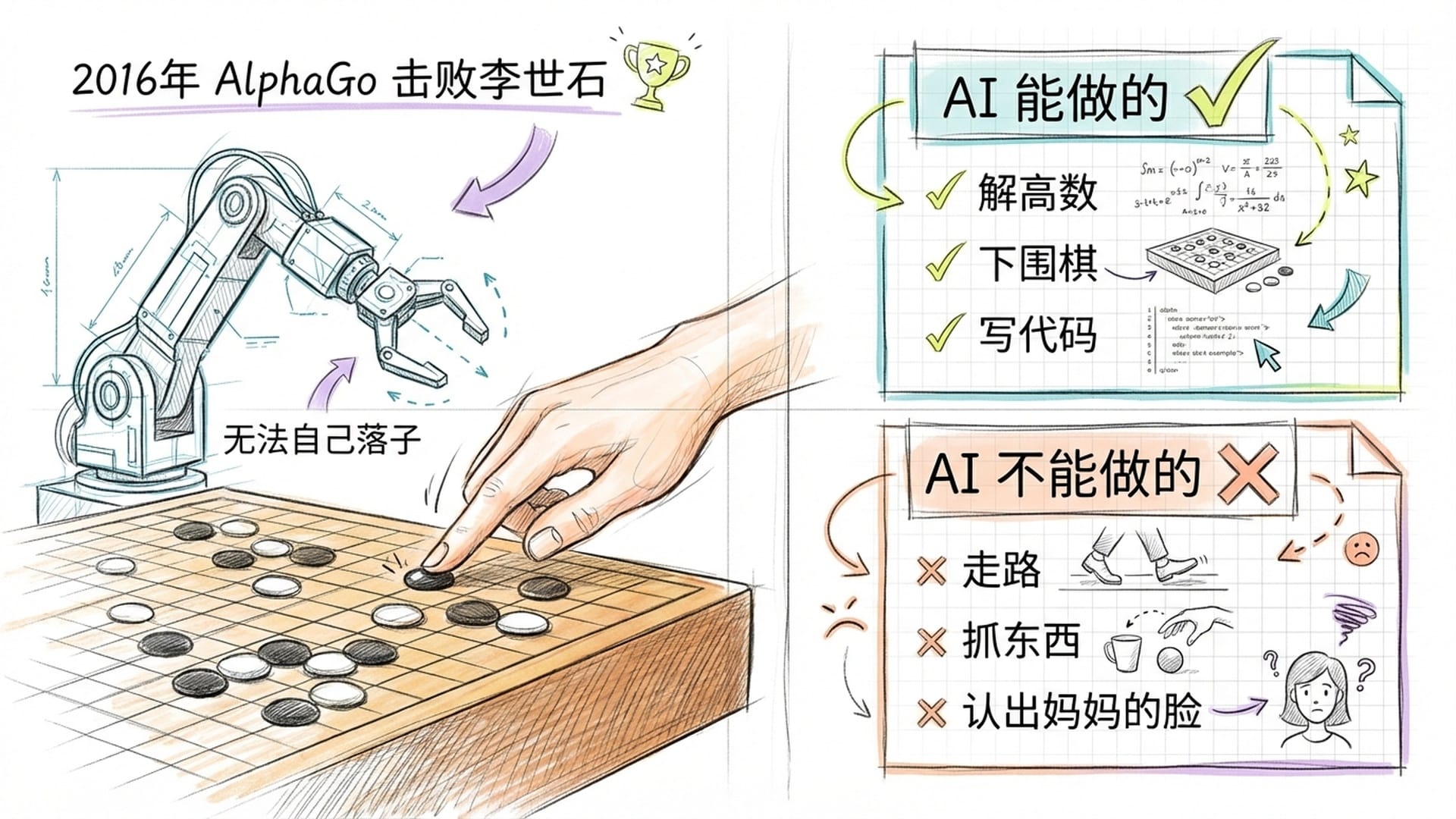

2016年AlphaGo击败李世石的时候,替它把棋子放到棋盘上的,是一个人类工作人员。这个能在围棋上碾压全人类的系统,连拿起一颗棋子这件事都搞不定。

人类觉得最难的事——解高等数学、下围棋、写代码——AI已经做到了顶尖水平。但人类觉得最简单的事——走路、抓东西、认出妈妈的脸——AI至今还在苦苦挣扎。

这不是巧合。这是人工智能领域最深刻的洞察之一,叫做莫拉维克悖论。

悖论的起源:三位先驱的洞见

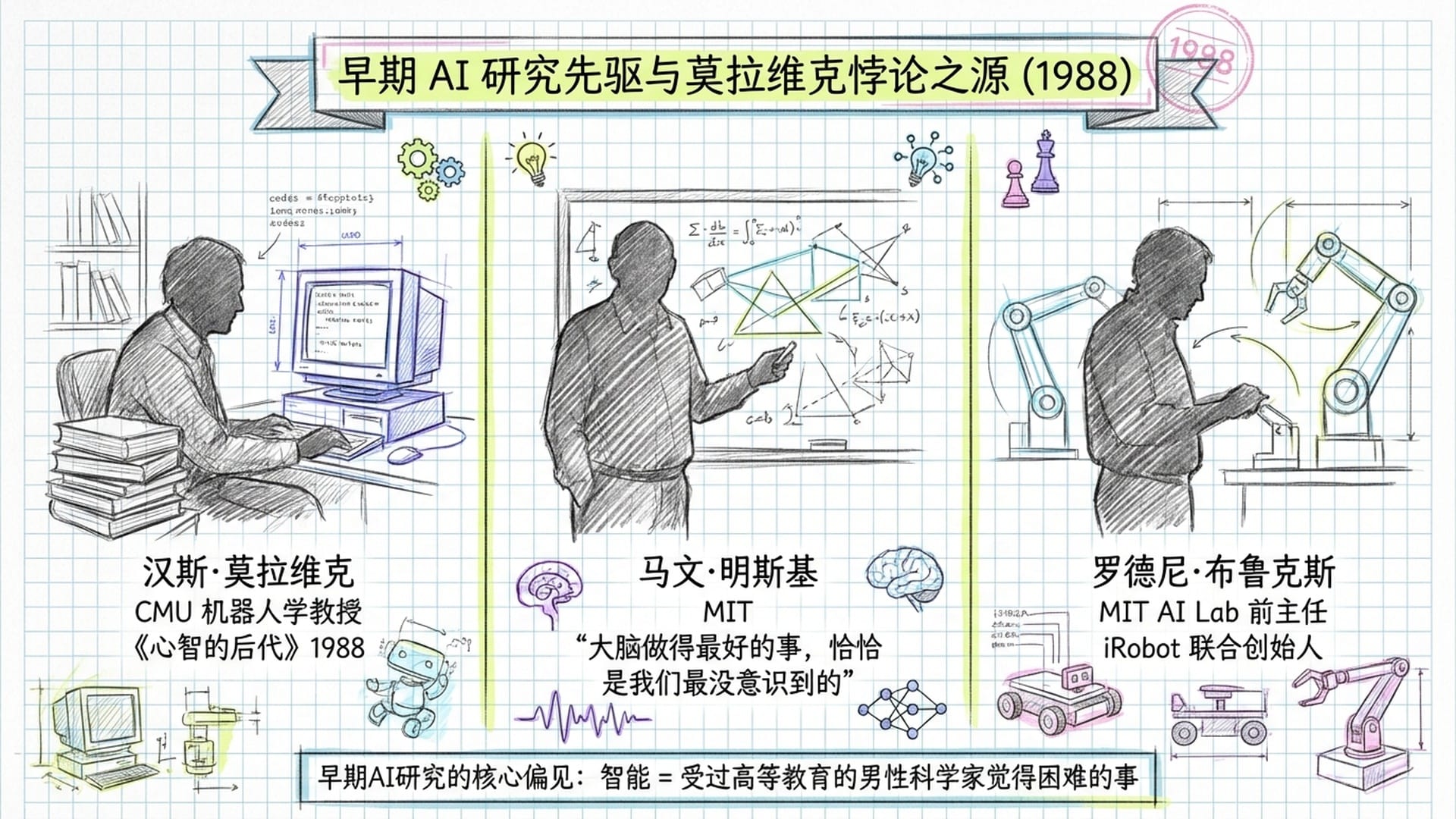

1988年,卡内基梅隆大学机器人学教授汉斯·莫拉维克在他的书《心智的后代》中写道:让计算机在智力测试或下棋上达到成年人的水平,相对来说比较容易;但要让它们拥有一个一岁小孩在感知和行动方面的能力,却极其困难,甚至不可能。

同一时期,MIT的马文·明斯基说了一句格外精辟的话:

总体来说,我们的大脑做得最好的那些事情,恰恰是我们最没有意识到的。

还有罗德尼·布鲁克斯,MIT人工智能实验室前主任、iRobot联合创始人。他指出了早期AI研究中一个被忽视的偏见:研究者们定义智能的方式,基本上就是受过高等教育的男性科学家觉得困难的事情——下棋、证明定理、解方程。

至于四五岁小孩毫不费力就能做到的事情——区分杯子和椅子、两条腿走路、从卧室走到客厅——没有人觉得这些需要智能。

但后来发现,恰恰是这些简单的事情,才是真正困难到令人绝望的挑战。

冰山模型:越意识不到,底层越复杂

莫拉维克自己给出的解释,是这个悖论最深刻的注脚。

他说:人类大脑中那些巨大的、高度进化的感觉和运动区域里,编码了大约十亿年关于这个世界的经验。而我们称之为推理的那个刻意思考过程,只是人类思维上最薄的一层表皮。它之所以有效,完全是因为它背后有那个古老得多、强大得多、通常无意识运行的感觉运动知识在支撑。

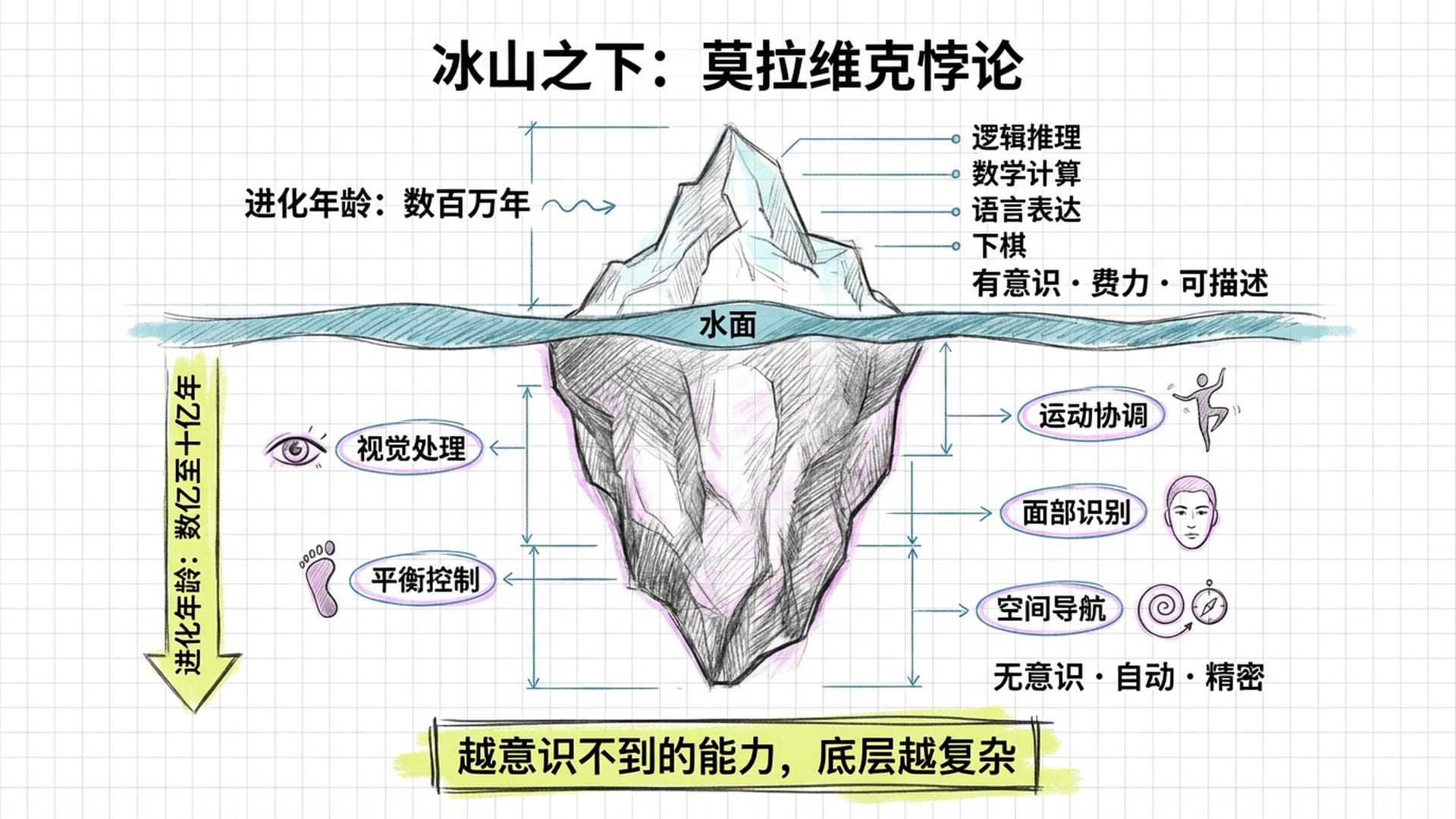

用一个更直觉的意象来理解:想象一座冰山。

露出水面的那一小部分,是你能够意识到的东西——逻辑推理、数学计算、语言表达、下棋。这些能力在进化史上非常年轻,满打满算也就是最近几百万年、甚至几千年才真正发展起来。因为时间短,自然选择还没来得及把它们打磨到极致,所以我们做这些事情时会感到费劲——你能意识到自己在思考。

而水面以下那个巨大的冰山主体,是你根本意识不到的东西——视觉处理、平衡控制、运动协调、面部识别、空间导航。这些能力从单细胞生物时代就开始进化,经历了数亿年乃至十几亿年的自然选择优化。它们被打磨得如此精密、如此高效,以至于你完全感觉不到它在工作。你走路时不需要想怎么走路,你看到一张脸时不需要算这是谁——它就是自动发生了。

莫拉维克悖论的核心:你越是意识不到一种能力,它在底层就越复杂。

拿起一个杯子,需要多少计算?

AI研究者们踩的坑正在这里。他们以为把难的搞定了,简单的自然就解决了。结果恰恰相反。

所谓的难——推理、下棋、解方程——只是进化上很新、还没来得及优化的能力。对计算机来说反而容易模拟,因为它本来就是一个规则清晰、边界明确的问题。而所谓的简单,是几亿年进化压力铸造出来的、高度优化的、分布在无数神经回路中的隐性知识——这东西你没法用规则写出来,因为连拥有它的人自己都不知道它是怎么工作的。

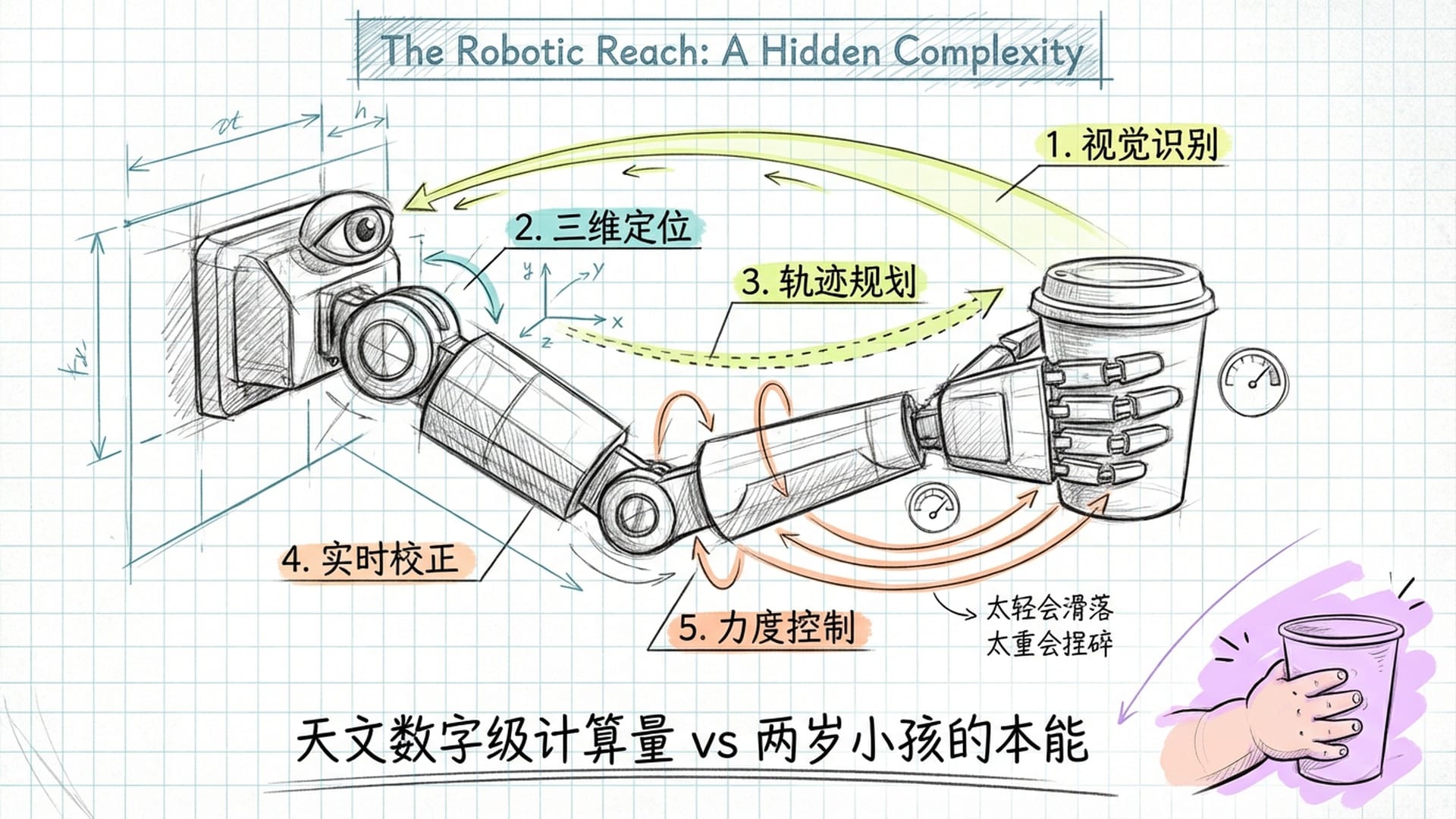

举一个最平凡的例子:你现在伸手去拿桌上的杯子。这个动作大概花了不到一秒钟。但如果你试图用计算机程序来实现它,需要解决什么?

首先,视觉系统需要从环境中识别出杯子,区分它与背景、桌面、旁边的其他物品。然后判断杯子的三维位置、方向和形状。接着,运动规划系统要计算手臂的轨迹——避开障碍物,选择合适的抓取角度。在手移动的过程中,视觉信息不断更新,肌肉力反馈持续变化,需要实时校正。最后手指合拢时,力度要刚刚好——太轻会滑落,太重会捏碎。

整个过程涉及的自由度、反馈回路、实时校正的计算量,是天文数字级别的。

但你——一个两岁的小孩——不需要任何人教你怎么计算这些。你只是伸手一拿,拿到了。

这就是十亿年进化给你的礼物。而这份礼物太好了,好到你根本不觉得它是礼物。

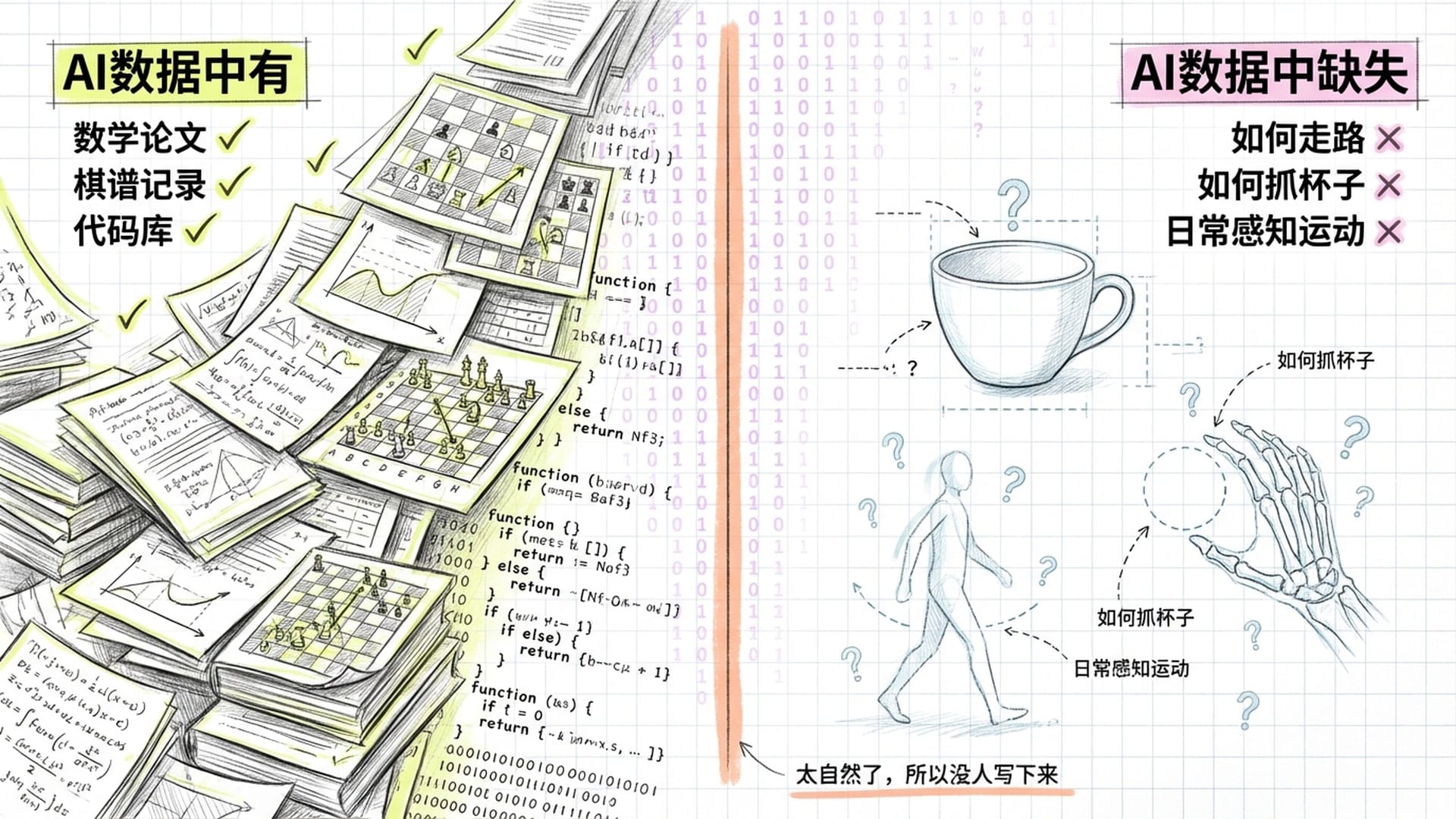

数据可得性:悖论的现代注脚

莫拉维克悖论在今天的语境下,还有一个全新的解释维度——它不仅仅是关于进化复杂度的问题,也是一个关于数据可得性的问题。

AI通过压缩互联网上的文本数据,学到了推理和知识。但互联网上有海量的数学论文、棋谱、代码,却几乎没有如何走路``如何拿杯子的数据。原因很简单——这些事情太简单了,没人会写下来。没有人会写一篇论文教你怎么抓杯子,但所有人都在写论文教你怎么解微分方程。

AI最擅长的,恰恰是人类花了最多精力去显性化、文字化、记录的那些能力。而AI最弱的,是人类从来不觉得需要记录的那些能力——因为它们太自然了,自然到我们忘了它们的存在。

这与道德经所说的语言是有损压缩完全一致。那些最深层、最本质的知识,恰恰是最难用语言表达的。不是因为我们不想表达,而是因为这些知识从来就不是以语言的形式存在的。它们是身体知道的,不是头脑知道的。

2025年的现代版悖论

2025年的AI领域出现了一个格外有趣的现象——AI在数学和编程上以令人目瞪口呆的速度进步,多个实验室的模型在国际数学奥林匹克竞赛中达到金牌水平,氛围编程成了潮流,很多人甚至不用看代码就能做出产品。

但在另一个方向上,AI操作电脑的能力——所谓的computer use agent,电脑使用代理——进展却慢得令人沮丧。俄亥俄州立大学的研究者Yu Su把这称为现代版莫拉维克悖论:AI在符号推理上一路狂飙,但在操作数字界面这种人类觉得轻而易举的事情上,表现依然很不稳定。

仔细想想,用电脑对你来说有多简单?打开浏览器、点一个按钮、在搜索框输入一句话、滚动页面找信息。你完全不用想这些步骤,手指自动就完成了。但对AI来说,它需要理解屏幕上每一个像素的含义、理解按钮和文字的空间关系、理解点击的时序逻辑,还要应对各种意想不到的弹窗和页面变化。

这和机器人抓杯子本质上是同一个问题——表面简单,底层极其复杂。

有一家叫Physical Intelligence的公司,从2024年底开始让机器人完成一系列看起来极其简单的日常任务:把花生酱抹到面包上、洗一个油腻的锅、把钥匙插进锁里、把袜子翻面。对你来说完全不用想的事,对机器人来说,每一个都是世界级的技术难题。

两条路径的相向而行

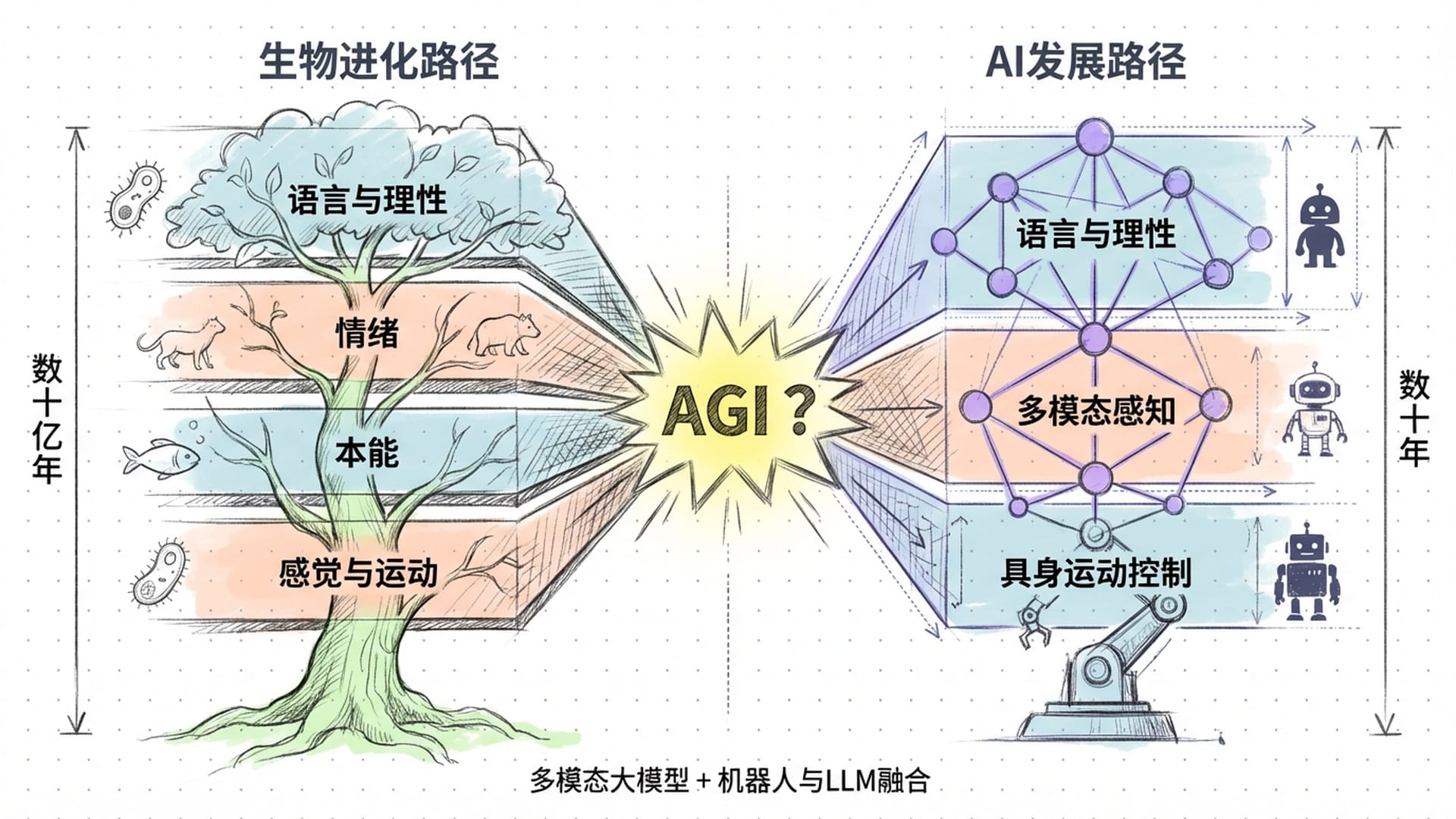

生物进化的路径是自下而上——先有感觉,再有运动,再有本能,再有情绪,最后才有语言和理性。而AI走了一条完全相反的路径——自上而下——先有语言和理性,然后试图往下延伸到感知和运动。

目前的AI,掌握了最上面几层的涌现——语言、推理、符号操作——但缺少最底下那些层——感知和运动这些古老的智慧。它就像一棵没有根的树,花开得很漂亮,但飘在空中。

这两条路径能否最终汇合?如果能,那就是AGI。如果不能,我们可能需要重新定义什么叫通用智能。

从目前的趋势来看,它们正在汇合——多模态大模型已经开始处理图像、声音、视频,机器人公司开始把大语言模型和具身控制结合起来。但莫拉维克悖论提醒我们,不要低估这个融合的难度。那几十亿年进化堆出来的东西,不是随便几万块GPU就能补上的。

意识只是冰山的尖尖

莫拉维克悖论还有一个延伸到意识本质的推论,格外令人不安。

明斯基说得好——我们对大脑做得最好的事情最缺乏意识。你的视觉系统每秒钟处理的信息量,比你一辈子的语言思考加起来都多,但你对它完全没有觉察。你的运动系统协调着几百块肌肉的精密配合,但你对它一无所知。

那么反过来想——你唯一觉察到的那个思考的声音、那个叙事的自我、那个我在想的感觉——有没有可能,这恰恰是你的大脑做得最粗糙的那一部分?

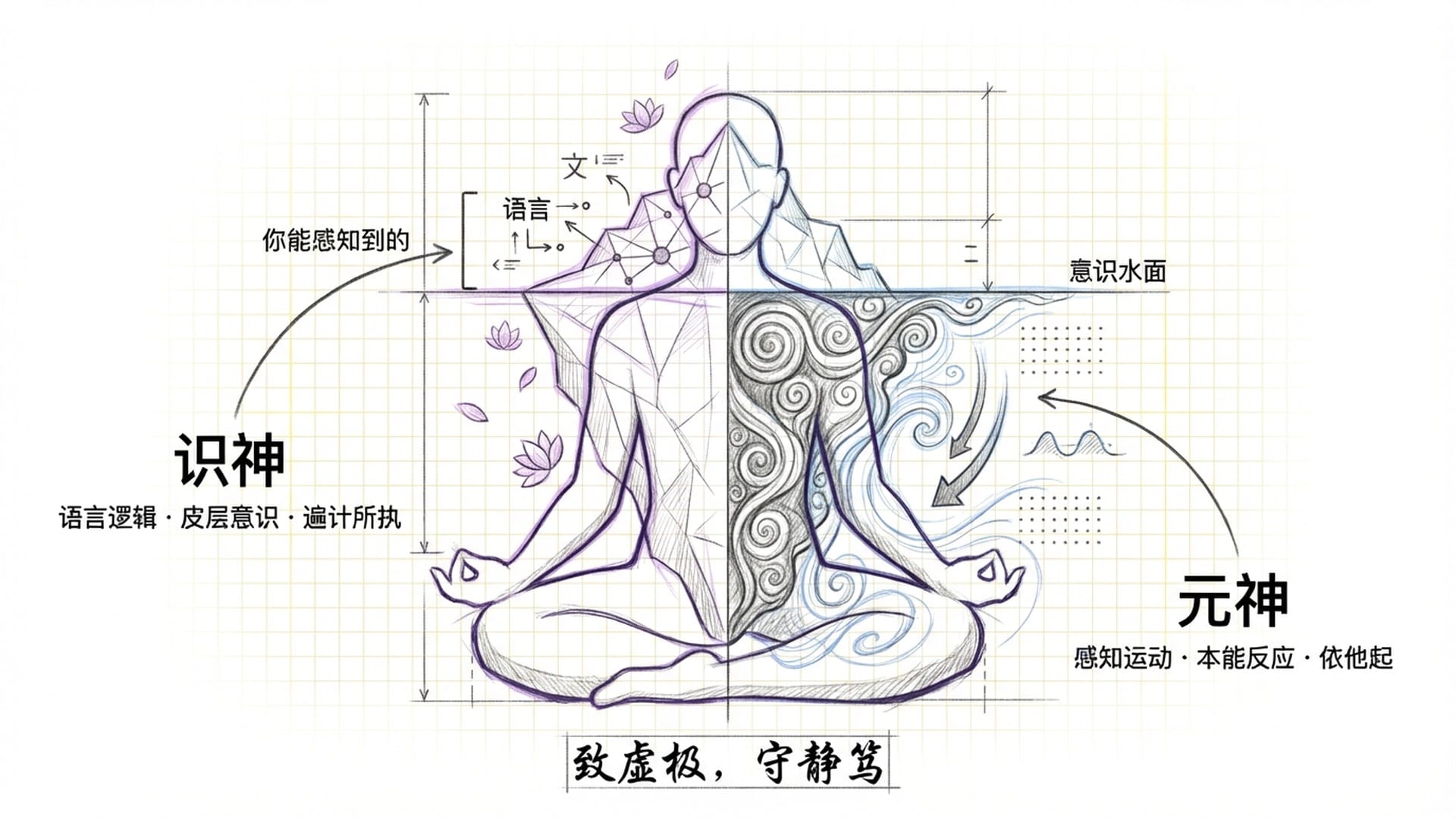

如果智能的绝大部分是无意识运行的,那么我们平时引以为豪的聪明``智慧``思考——在整个智能版图中,占多大比例?答案可能让你不舒服:非常非常小。修行传统中所说的识神与元神的关系,与莫拉维克悖论描述的结构几乎同构。识神——日常意识、语言逻辑思维、大脑皮层的默认模式网络——就是冰山露出水面的那个薄薄表层。元神——那个底层的感知、运动、本能反应构成的深层系统——是冰山水面以下的巨大主体。

修行所说的致虚极,守静笃,用莫拉维克悖论的语言来翻译就是:暂时关闭那个最年轻、最粗糙、最喧闹的模块,去感受那个运行了几十亿年的、安静而精密的底层系统。

你都不知道自己知道的事情

莫拉维克悖论不仅仅是一个AI的技术问题。它是一面镜子。

人类真正的超级能力不是我们引以为豪的理性思维——那只是薄薄的表皮。真正的超级能力,是那些你根本意识不到的东西。而AI之所以暂时还不能替代人类,恰恰是因为它还没学会那些你都不知道自己知道的事情。

如果你只用理性、语言和逻辑思维去理解世界,你其实是在用冰山的尖尖去理解整座冰山。这大概就是为什么最深的智慧往往是说不出来的——因为它本来就不住在语言能够到达的地方。

莫拉维克悖论的终极启示:不要小看任何一个简单的事情。一个两岁小孩伸手拿到一块饼干,这个动作背后站着十亿年的进化智慧。我们人类最大的认知盲区,可能正是——对自己真正的能力视而不见,却对那层最薄的表皮沾沾自喜。

|  |  |  |