王利杰:程序员,你是否感到前所未有的“落后感”?卡帕西时刻与AI新范式生存指南

特斯拉前AI总监Andrej Karpathy直言“从未如此落后”,引发“卡帕西时刻”行业核爆。本文深入探讨AI时代程序员面临的“可能性过剩”与职业转型,剖析从“确定性工程”到“概率性意图编排”的范式迁徙,并提供最新的AI原生技术栈生存指南。

|  |  |  |

卡帕西时刻:程序员的集体核爆与生存指南

深夜,屏幕投射出幽蓝的光芒,你是否也曾像我一样,在刷着社交媒体时,被一条突如其来的消息击中,它如同闪电般劈开了你对未来所有的假设?这则消息并非来自某个新产品的发布,也不是某家科技巨头的财务报告,而是出自特斯拉前AI总监、全球AI领域的顶尖人物 Andrej Karpathy 之手。他写道:“作为一名程序员,我从未感到如此落后。”

这句话如同一枚重磅炸弹,瞬间引爆了整个行业,引发了我们称之为“卡帕西时刻”的集体核爆。它不仅仅是谦逊之词,更是对行业底层逻辑崩塌的敏锐洞察。这就像一位F1赛车手突然宣称自己不知道如何驾驶了,那种震撼,需要我们细细体会。

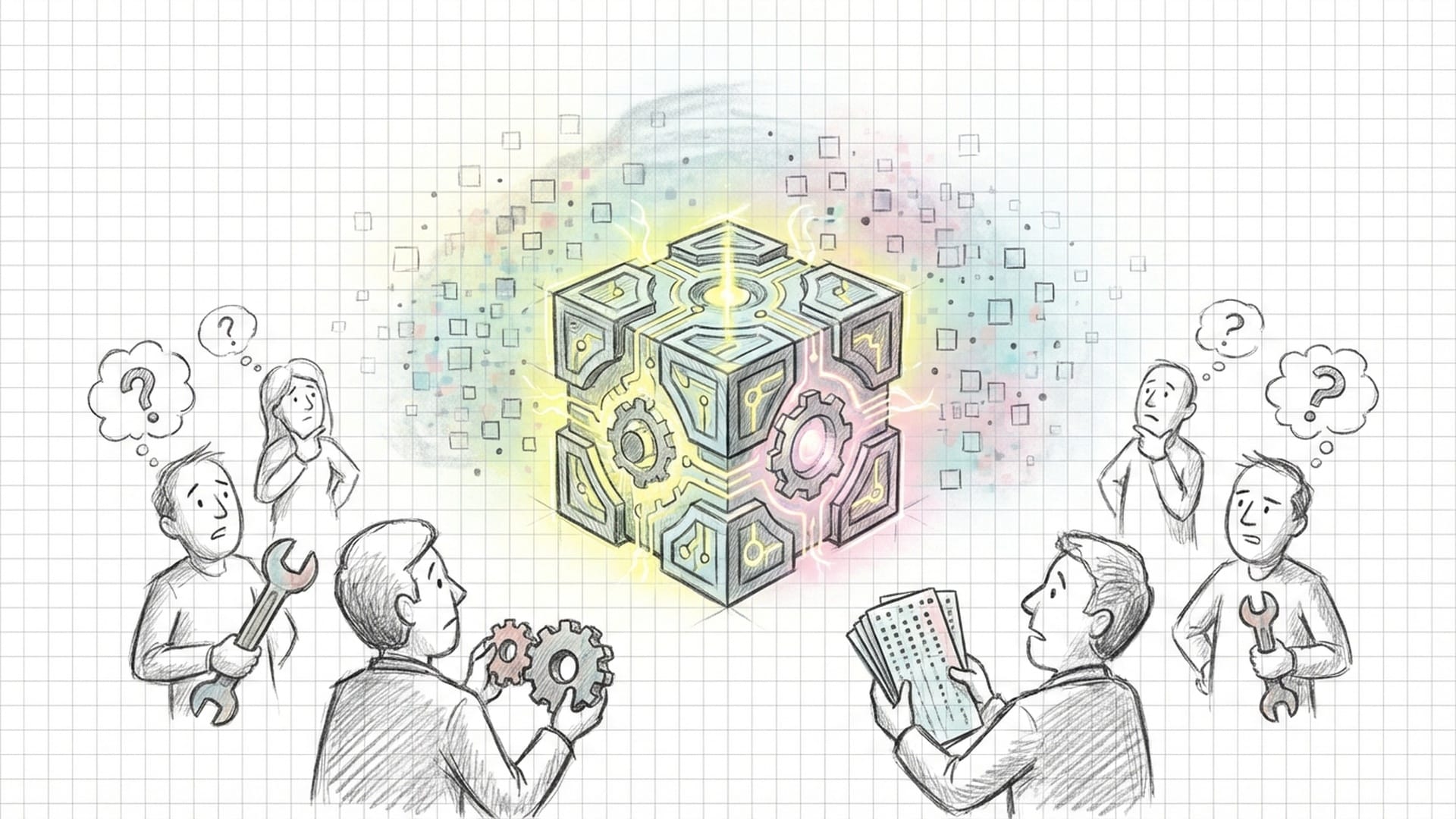

卡帕西所描述的是一种深刻的脱节感:我们程序员贡献的“比特”正在日益稀疏,而底层代码与最终产出之间,悄然出现了一个崭新的、庞大而无形的“可编程抽象层”。他将其比作**“强大的外星工具”**——这些工具被甩到我们手中,却没有说明书,令所有人都手足无措。与此同时,一场里氏九级的大地震正在撼动我们整个职业的地基。

这种“落后感”并非源于技术不精,而是因为可能性过剩。卡帕西坦言,如果能正确串联起过去一年涌现的所有工具,他的能力本可以提升十倍。他未能做到,因此感到“像是技能问题”。这句话如同一把手术刀,精准地切开了每位工程师内心最深处的不安:当工具的进化速度超越了人类认知的适应速度,我们是否正在不可避免地沦为旧时代的遗民?

软件工程的“地质变迁”:从建造者到引导者

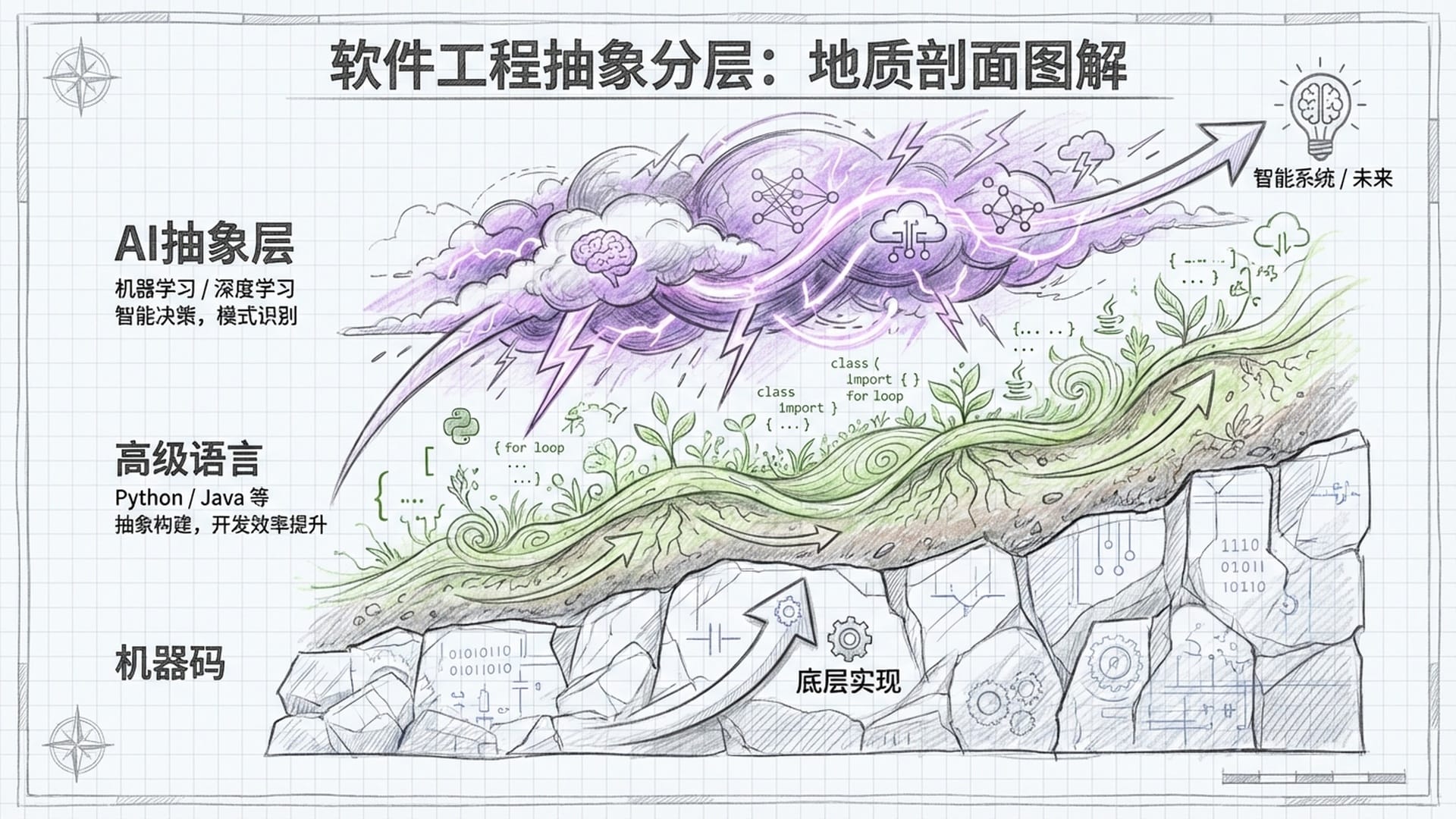

要理解这场“地震”的本质,我们不妨借用软件工程的地质学隐喻。过去几十年,软件工程的抽象层级如同地质沉积物般,缓慢而稳定地积累。最深处是冰冷的机器码、汇编语言,它们是坚硬的基岩。向上是C语言、操作系统内核,构成了稳定的岩石层。再往上,是Java、Python等高级语言形成的肥沃土壤,以及无数开源库和API构成的繁茂植被。

在这个旧世界中,我们工程师是地质学家,是矿工。我们向下挖掘,探寻确定的逻辑,构建坚固的城堡。每一行代码都是一块砖,依照蓝图堆砌,大厦便能屹立不倒。

然而,卡帕西所描述的**“新可编程抽象层”**,并不属于这个传统地质结构。它更像一场突然降临的、充满电荷的风暴,悬浮在所有地层之上。这个新的层级——代理(Agent)、子代理(Subagent)、提示词(Prompt)、上下文(Context)、模型上下文协议(MCP)——本质上是流动的、气态的、混沌的。它不再遵循牛顿力学般的确定性逻辑;你输入A,不一定会得到B,它甚至可能还会出现“幻觉”C。

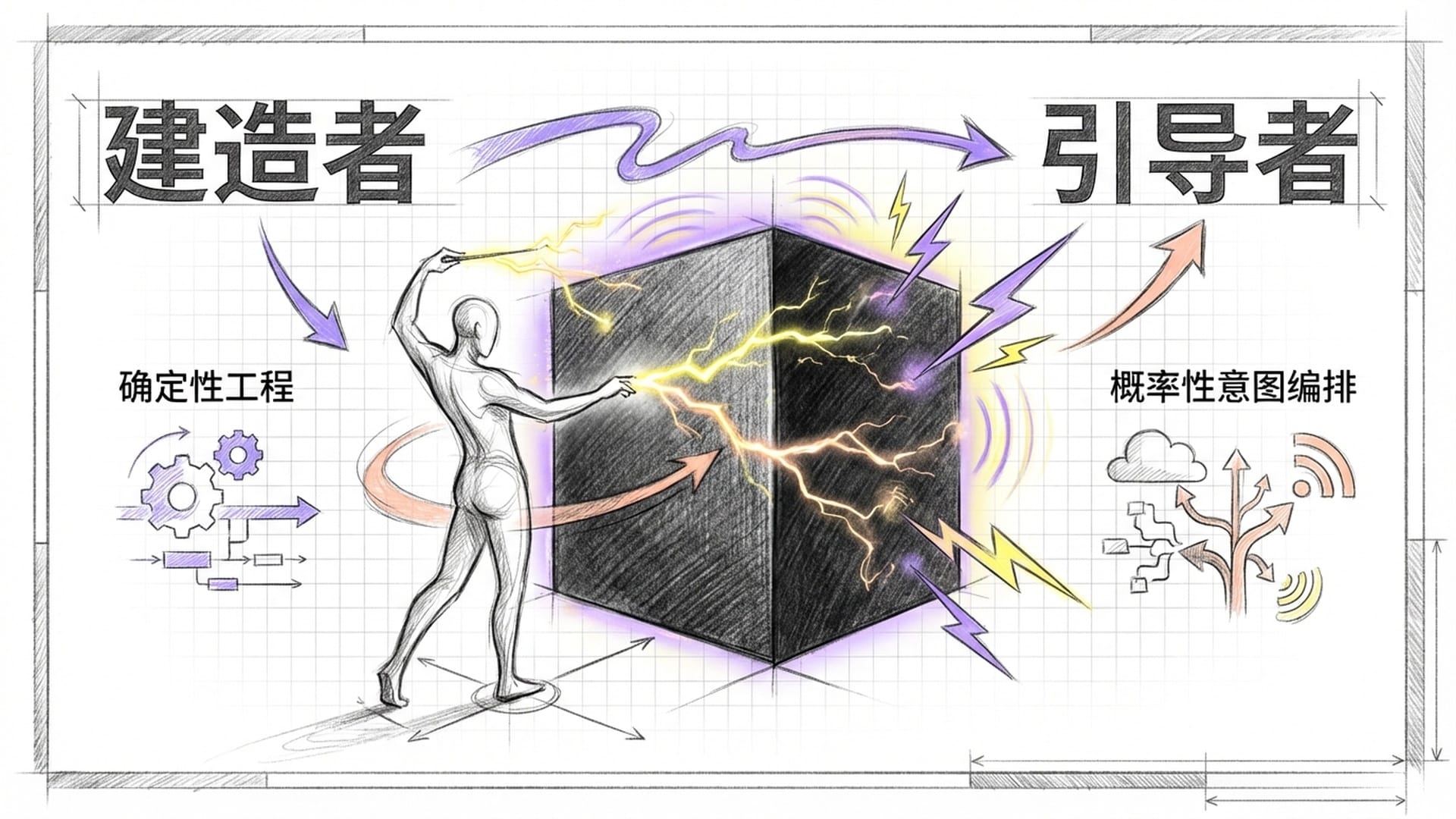

人类工程师的地位正在发生根本性位移。我们被迫从脚踏实地的“建造者”,转变为在风暴中试图驾驭闪电的**“引导者”。这种转变不仅要求我们技能重置,更要求心智模型彻底重构。我们习惯了控制,而现在必须学会与随机性共舞。我们习惯了理解每一行代码的执行路径,而现在必须面对一个不可解释的黑盒。正是这种从“确定性工程”向“概率性意图编排”**的迁徙,造成了全行业普遍的“存在主义焦虑”。

这并非一次肤浅地讨论“AI会帮你写代码”的趋势,而是深入探讨在这场编程范式的大迁徙中,我们如何才能不被淘汰,反而成为新时代的赢家。这不是锦上添花,而是生存指南。

AI原生技术栈的核心要素:代理与多代理协作

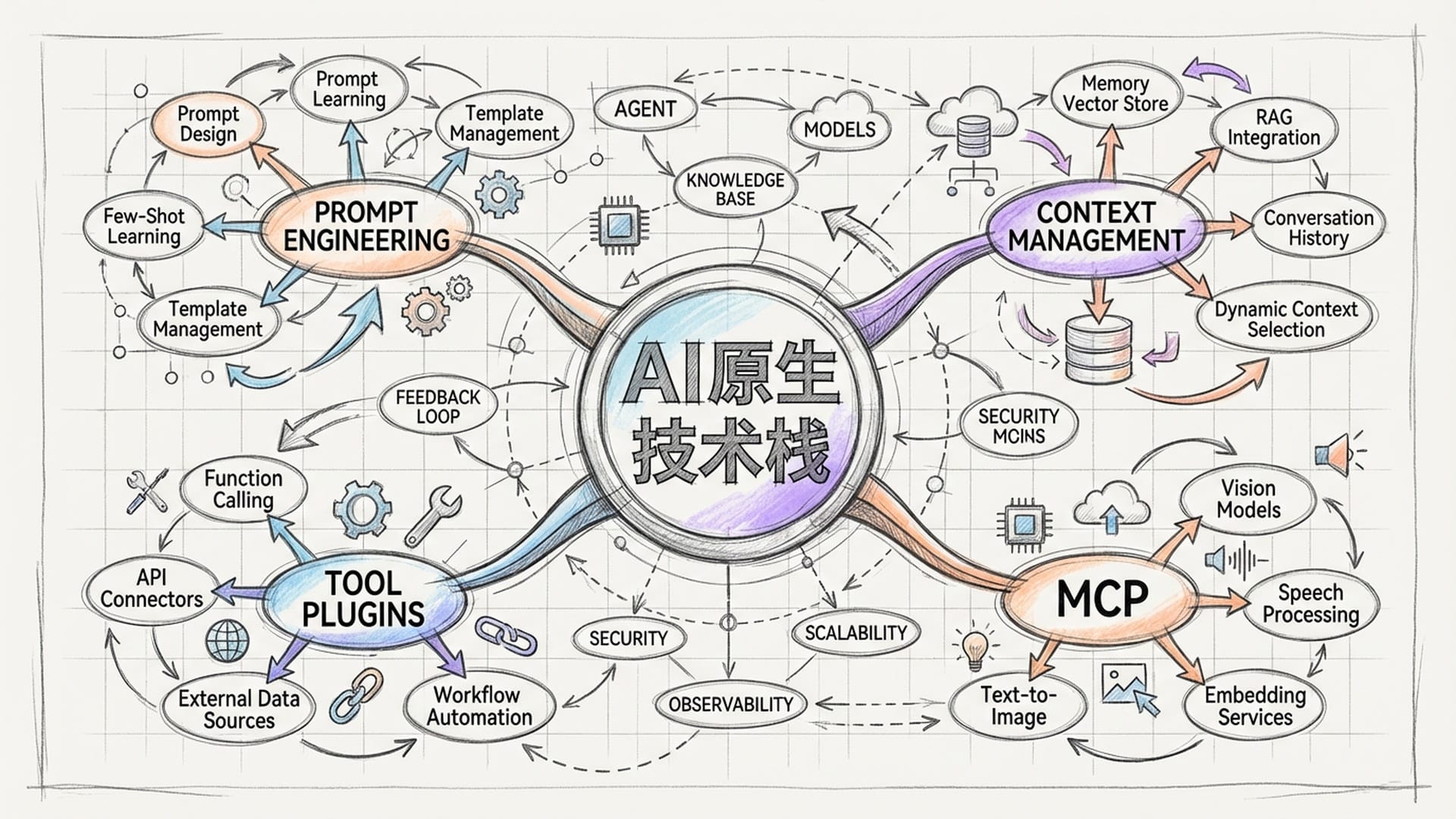

Karpathy在推文中列举了一系列令人眼花缭乱的新术语:Agent, Subagent, Prompt, Context, Memory, Modes, Permissions, Tools, Plugins, Skills, Hooks, MCP, LSP, Slash commands, Workflows, IDE Integrations。这绝非随意堆砌,而是对正在形成的**“AI原生技术栈”**的精确描绘。过去一年最重要的突破之一,正是这个新抽象层开始有了清晰的轮廓,它不再仅仅是ChatGPT对话框中的文字游戏,而是演变为结构化、可组合的工程系统。

在计算机科学的传统语境中,最基本的复用单元是函数。函数是无状态的、被动的、确定性的:你调用它,它计算,然后返回结果。然而,在新抽象层中,核心计算单元变成了代理(Agent)。

与函数不同,代理是有状态的,并且具有主动性。它不只是响应输入,它有自己的目标。当你给一个代理指令——“修复这个Bug”——它不会简单地执行一段代码。它会进入一个循环:观察环境、制定计划、采取行动(例如读取文件),然后观察结果,接着调整计划,直到目标达成,或者彻底失败。

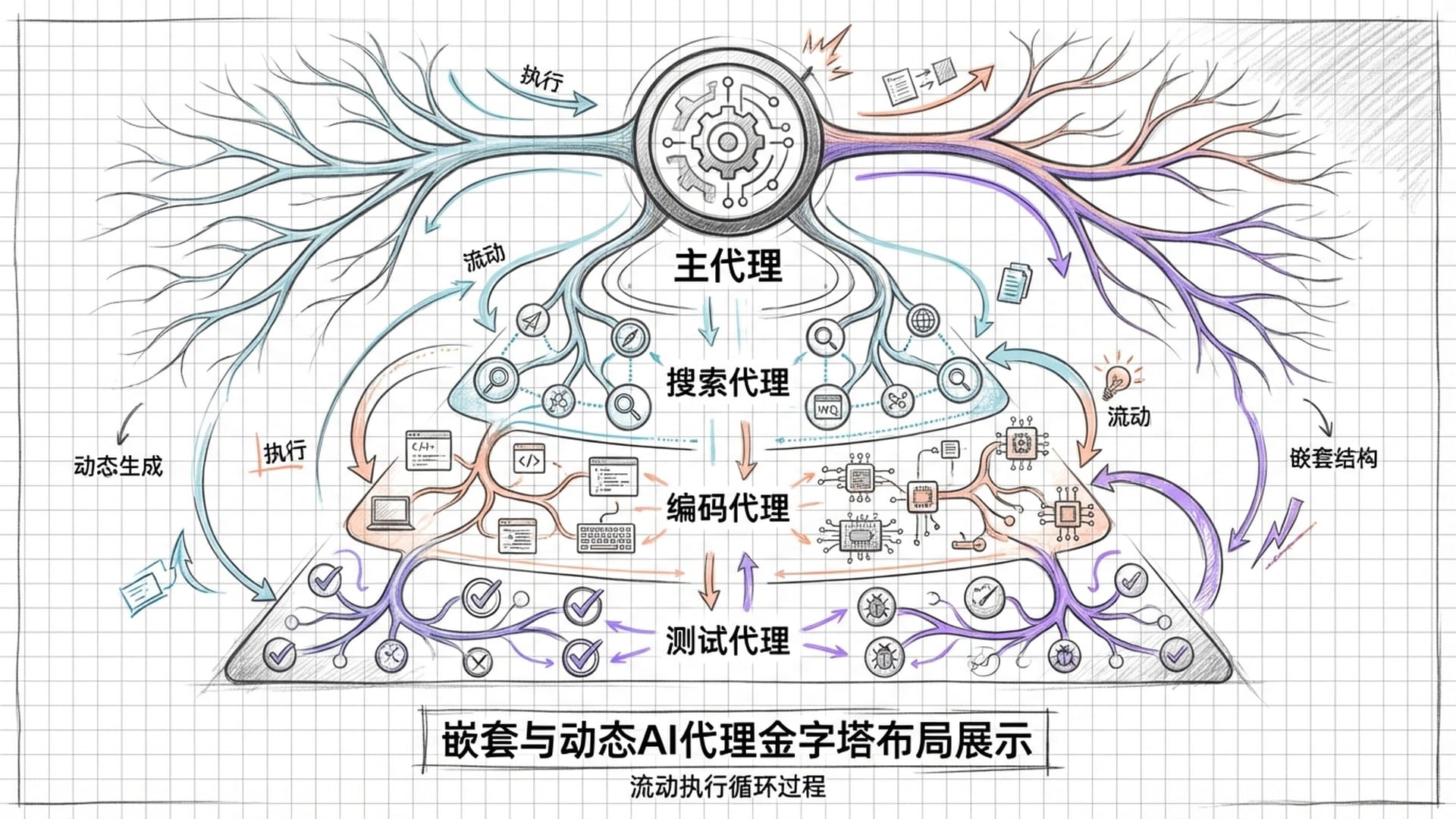

Karpathy提到的**“子代理”(Subagent)进一步揭示了这种架构的分形特征**。在复杂的任务中,主代理不再需要亲力亲为,它会像人类管理者一样,动态地孵化出专门的子代理。例如,一个负责“构建Web应用”的主代理,可能会指派一个“搜索子代理”去查找最新的库文档,指派一个“编码子代理”去撰写后端逻辑,指派一个“测试子代理”去运行单元测试。这种层级化的多代理协作,正在重构软件的开发流程,它更像是一个生物组织在自我修复和生长,而非机械的装配工厂。

从“提示词工程”到“语境工程”:新的范式转移

在新的层级中,提示词(Prompts)不再是简单的聊天输入,它们已然成为新时代的“源代码”。然而,这种“源代码”具有极高的不稳定性。在C++中,std::cout的行为是全球统一的,但在大语言模型中,同样的提示词,在不同的模型版本,甚至同一版本的不同运行中,可能产生截然不同的结果。

这促使“提示词工程”向**“提示词版本控制”和“自动化评估”演进。工程师们开始像管理代码库一样管理提示词库,使用Git进行版本控制,并建立自动化评估管线(Eval Pipelines),以测试提示词变更对输出质量的影响。Karpathy将提示词列为新抽象层的核心要素,暗示了自然语言**正在成为一种非确定性的编程语言。

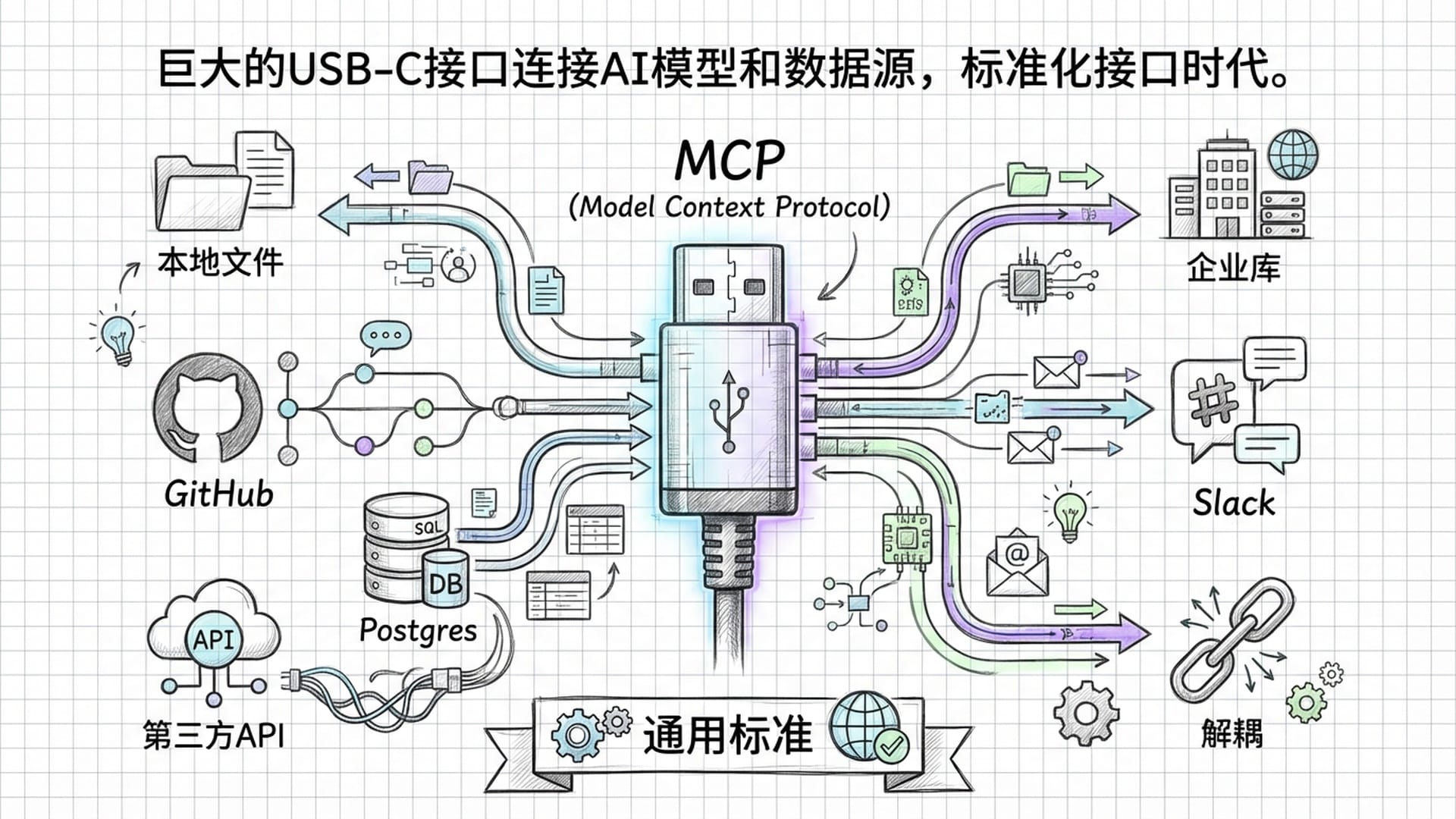

Karpathy的清单中,**MCP(模型上下文协议)和LSP(语言服务器协议)**并列出现,这具有深刻的含义。LSP是微软十年前推出的协议,它标准化了IDE与编程语言工具之间的沟通(如代码补全、跳转定义),是上一代开发效率革命的基石。而MCP,则是AI时代的LSP。

长期以来,大模型一直被困在“信息孤岛”中。即使是最先进的模型,如Claude 3.5 Sonnet,拥有惊人的智能,但它们生活在真空中,无法访问你的本地文件,无法查询你公司的数据库,也无法读取你的日历。每一次新的数据源连接都需要定制化开发,这导致了系统碎片化和高昂的集成成本。

未来一年,关键性的突破将是MCP(模型上下文协议)的诞生和普及。Anthropic将其比作“AI应用的USB-C接口”。就像USB-C标准化了硬件连接一样,MCP标准化了AI获取上下文和调用工具的方式。MCP采用经典的客户端-主机-服务器架构:开发者可以构建“MCP服务器”来暴露数据或工具;AI应用作为“MCP客户端”来消费这些资源。这种解耦方式使得生态系统能够指数级地扩展。

通过MCP,AI不再是一个只会聊天的机器人,而是一个能直接在你本地环境中执行复杂任务的实体。例如,它可以连接到GitHub的MCP服务器读取Issues;连接到Postgres的MCP服务器分析数据;再连接到Slack的MCP服务器发送报告。所有这些都无需AI模型本身进行硬编码的适配。

人类的角色:从驾驶员到副驾驶

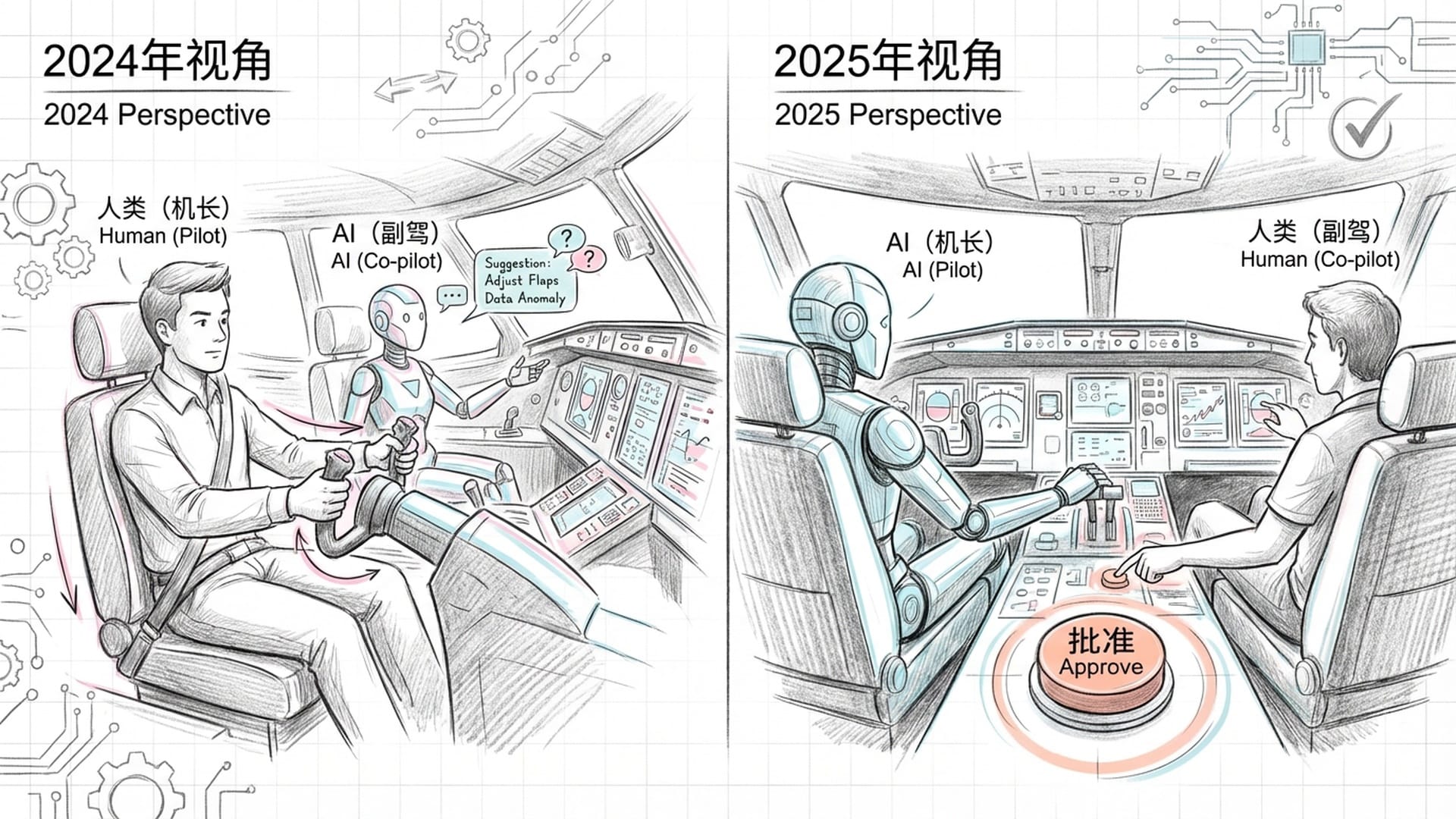

如果说Karpathy指出了工具的变化,那么NVIDIA高级科学家Jim Fan则进一步阐述了这种变化对人类角色的哲学影响。他提出了一个引人深思的观点:“2024年,AI是副驾驶;2025年及以后,人类是副驾驶。”

过去,“Copilot”这个词暗示着人类依然紧握方向盘,AI只是在旁边提供导航建议或自动补全。人类拥有完全的代理权,即发起行动和做出决策的权力。然而,随着**代理工作流(Agentic workflow)**的成熟,这种关系正在发生倒置。在新的模式下,AI代理可能会主动发起任务、规划路径,甚至在遇到障碍时尝试自我纠正。人类的角色,退化(或说是进化),为监督者和最终决策者。

你可以想象一下,2024年的模式是:人类说,“写一个函数来解析这个JSON。”AI生成代码,人类粘贴并修改。但到2025年以后,模式可能会是这样:人类说,“为项目增加一个用户登录功能。”AI代理会说,“好的,我制定了以下计划:一、修改数据库Schema;二、更新后端API;三、编写前端页面。我现在开始执行第一步,需要你授权数据库访问权限。”而人类,只需要说,“批准。”

Jim Fan指出:“离开驾驶员座位并非易事——我们必须学会用AI的方式思考,适应陌生的工作流程。帮助AI帮助我们。”这种心理阵痛,正是Karpathy所说的“焦虑”的核心来源之一。

对于习惯了掌控每一个字节的传统程序员来说,看着AI自动修改数十个文件、运行测试,甚至提交代码,会产生一种本能的恐惧。这种恐惧不仅来源于对代码质量的担忧,更来源于对**“失控”**的恐惧。我们被迫信任一个本质上是概率性的实体。

这种转变,类似于你从驾驶手动挡汽车到乘坐自动驾驶汽车。在手动挡时代,驾驶员通过离合器和油门直接感知引擎的震动;在自动驾驶时代,乘客只能通过屏幕上的可视化界面,间接了解车辆的意图。工程师必须学会建立对AI的**“信任模型”**,通过观察它的推理过程,而非底层代码,来判断其可靠性。

语境工程:AI原生工程师的新基本功

随着“提示词工程”这个词逐渐显得过时,一个新的、更具系统性的工程学科正在崛起——语境工程(Context Engineering)。Google工程负责人Addy Osmani是这一概念的主要倡导者。

“提示词工程”暗示了一种魔法般的技巧——只要你找到那句完美的咒语,AI就能做任何事。然而,现实并非如此。Addy Osmani指出:“提示词工程,往往在没有强大语境管理的情况下失败。”无论你的指令多么精妙,如果AI不知道你的数据库结构、不懂你的遗留代码风格、不清楚你的业务约束,它生成的代码就是不可用的废品。

因此,工程师的关注点,正从“如何对AI说话”,转移到**“让AI知道什么”**。语境工程不仅仅是将文件粘贴到对话框里,它是一门关于信息架构和Token经济学的科学。它的定义是:为AI提供成功完成任务所需的所有信息和工具的系统化过程。

在有限的上下文窗口内,即使是百万个Token,也是有限的,每一个Token都是宝贵的资源。塞入无关信息,不只浪费金钱,还会稀释AI的注意力,导致“迷失中间”现象,即模型忽略了上下文中部的关键指令。

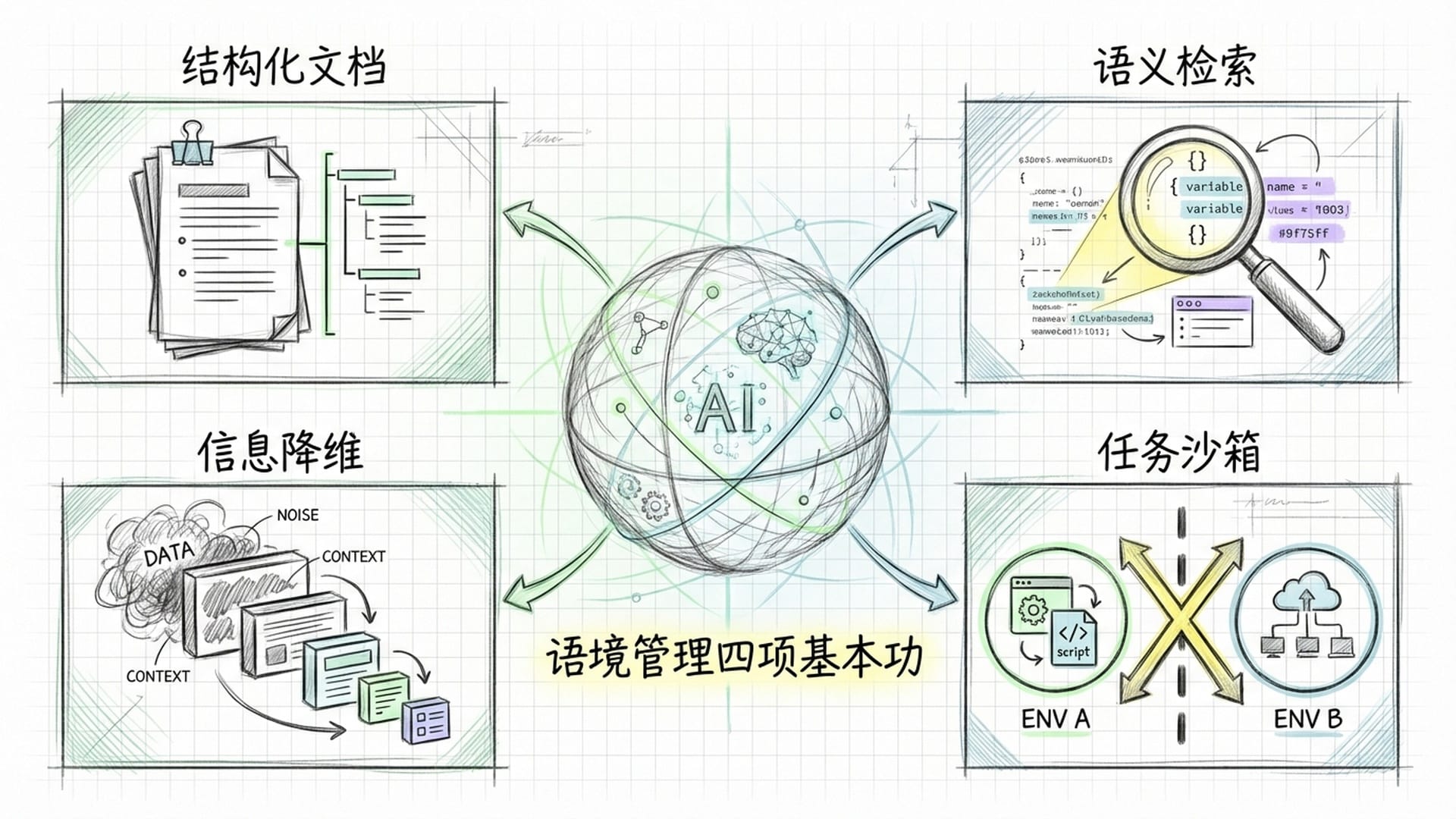

Addy Osmani提出了语境管理的四个关键支柱,它们构成了AI原生工程师的新基本功:

- 编写(Write):你要为AI而写。未来的文档读者不只是人,还有AI。工程师需要编写结构化极强的文档,例如

系统指令.md文件,清晰定义项目的架构模式、命名规范和依赖关系。你的代码本身的注释和命名,也需要更加显性,因为这直接构成了AI理解代码意图的线索。 - 选择(Select):这是RAG(检索增强生成)的微观化应用。工程师需要掌握如何动态地从庞大的代码库中**“选择”出与当前任务最相关的片段。这不再仅仅是搜索,而是语义检索**。如果你要修复一个前端Bug,不要把后端数据库的迁移脚本扔给AI。学会只提供最小必要的上下文。

- 压缩(Compress):即信息降维。把冗长的错误日志压缩为关键的堆栈跟踪;把庞大的API文档概括为函数签名列表。你甚至可以利用AI本身来压缩历史会话,只保留决策点和关键结论,丢弃冗余的寒暄和试错过程。

- 隔离(Isolate):任务沙箱化。防止不同任务之间的上下文污染。如果AI刚刚在处理A模块,现在要处理B模块,最好清空上下文,或者明确划分边界,防止AI将A模块的变量名“幻觉”到B模块中。

“三人编程”:超越“感觉编程”的质量危机

卡帕西提到的**“十倍效率提升”极其诱人,但如果不加控制,这种效率的提升往往建立在质量的隐性债务之上。Addy Osmani极其敏锐地指出了当前AI编程浪潮中的主要陷阱——“感觉编程”(Vibe Coding)**。

什么是“感觉编程”?它指的是一种现象:工程师完全依赖AI生成代码,只要代码“看起来能跑”,或者没有报错,就认为任务完成了。工程师本人可能并没有逐行阅读代码,甚至完全不理解代码的实现逻辑。

这种模式在原型开发阶段极其高效,能让一个不懂React的人在半小时内搭建一个网站。然而,当这种模式进入生产环境时,灾难往往随之而来。

Addy Osmani警告说,AI非常擅长快速完成前70%的工作。它能迅速生成脚手架、样板代码,甚至核心逻辑的初稿。这给了开发者一种“我几乎做完了”的错觉。然而,真正的工程挑战往往在于剩下的30%:

- 边缘情况:AI通常只处理“快乐路径”,而忽略了异常处理、并发冲突、内存泄漏等复杂场景。

- 系统集成:生成的代码如何与现有的遗留系统交互?

- 非功能性需求:性能、安全性、可维护性。

当遇到这些问题时,如果工程师是因为“感觉编程”而跳过了理解阶段,他们将陷入瘫痪——面对一大坨由“外星人”写出的代码,完全不知道如何调试。这被称为**“最后的一英里差距”**。

Google的内部数据显示了一个令人警惕的趋势:在引入AI辅助编程后,Pull Request的审查时间反而增加了91%。这是一个反直觉的数据,按理说,AI写得更快,开发应该更快。但事实是,AI生成的大量代码虽然语法正确,但往往包含微妙的逻辑错误或不符合团队规范。

- 垃圾代码泛滥:以前一个工程师一天写100行代码,现在能生成1000行。审查者被海量的、平庸的、缺乏人类意图解释的机器代码淹没。

- 信任成本:审查者不敢信任AI生成的代码,不得不花费比审查人类代码更多的时间去逐行验证,因为AI不会像人类一样在逻辑不通时停下来,它会自信地编造。

这种**“写得快,审得慢”**的现象,正在抵消AI带来的效率红利,甚至导致整体交付速度的下降。

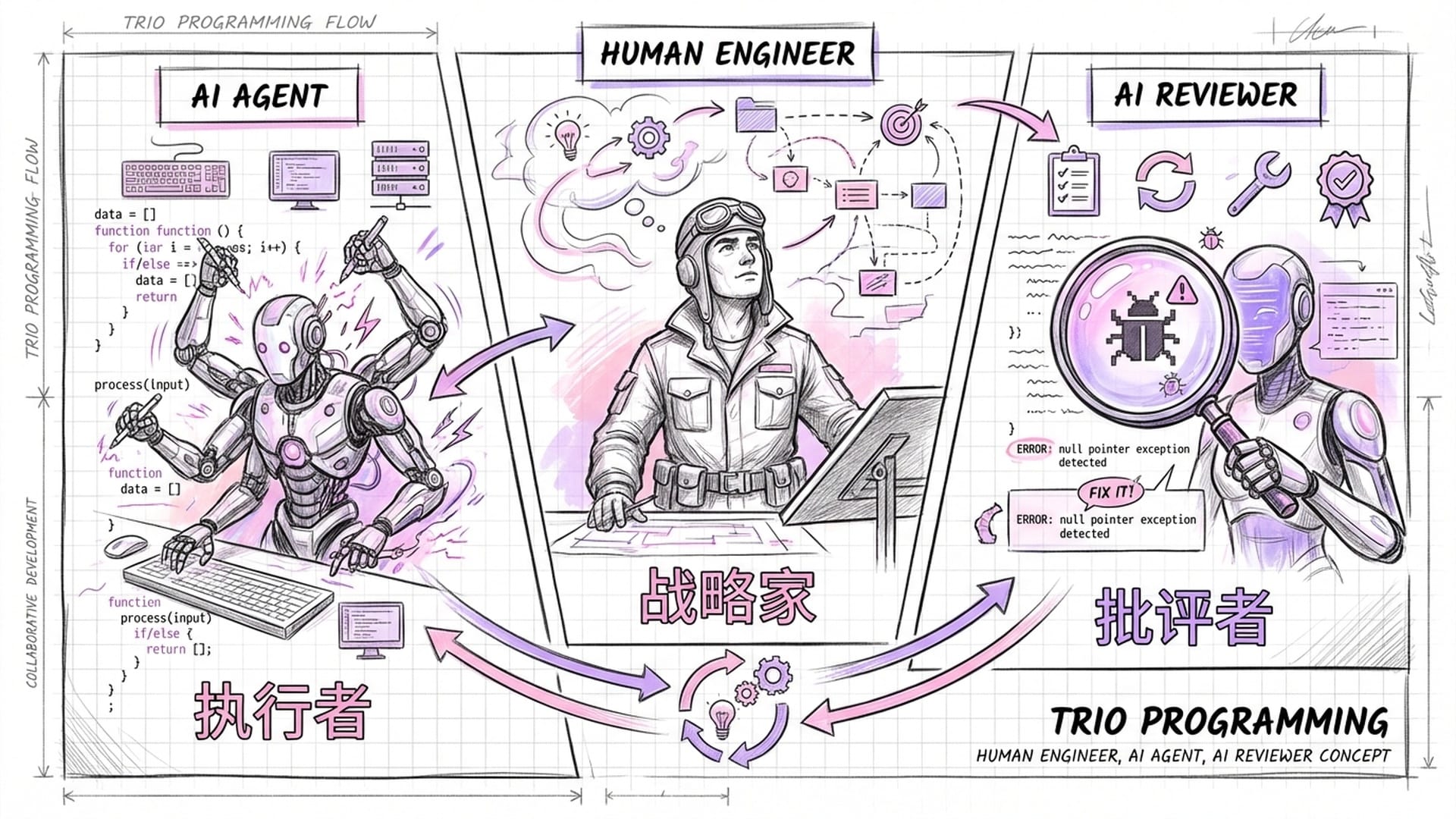

为了解决“感觉编程”带来的质量危机和“审查时间暴涨”的效率瓶颈,一种新的人机协作范式正在浮出水面。Addy Osmani将其命名为**“三人编程”(Trio Programming)**。

传统的“结对编程”(Pair Programming)是两个人工程师共用一台电脑,一个驾驶,一个导航。而在AI时代,这个组合演变成了三个角色的动态博弈:

- 人类工程师:你是战略家,是指挥官。你不再关注分号是否漏写,而是关注:我们到底要解决什么问题?这个架构是否合理?这个功能是否符合用户需求?你的职责是定义意图、提供语境、做出最终的“合并”决策。

- AI代理:它是超级实习生,也是不知疲倦的执行者。它的职责是生成代码、执行重构、编写测试、搜索文档。它负责将人类的战略意图转化为具体的战术实现。

- 审查者或验证者:这是很多团队忽视的关键第三方。它不再必须是另一个人类,它可以是一个专门配置为“批评者”角色的AI模型,也可以是一套极其严格的自动化测试和Linter套件。它的任务是寻找错误。它不生成代码,它只负责质疑。它会问:“这里的输入验证是否充分?”“这个循环在边界条件下会死循环吗?”

卡帕西提到,新工具是“随机的、易错的”。在“三人编程”模型中,审查者角色的引入正是为了对抗这种随机性:通过对抗性生成(让AI Agent生成代码,然后让Reviewer Agent去攻击这份代码),只有通过了Reviewer质疑的代码,才会被呈递给人类。这种“左右互搏”的机制,可以大幅过滤掉低级错误和幻觉,大大减轻了人类工程师的认知卸载,让他们能够将认知带宽集中在最高层级的逻辑判断上,从而有效解决“91%审查时间增加”的问题。

结语与行动指南:迎接新世界

虽然我们正处于剧变之中,但这仅仅是开始。关于Claude Opus 4.5和Gemini 3的传闻表明,下一代模型将带来更强的推理能力和代理能力,进一步加速这一进程。

目前的AI模型大多是**“快思考”系统,它们基于概率直觉迅速给出答案。而传闻中的Opus 4.5和Gemini 3,以及OpenAI的O1系列,正在向“慢思考”**系统进化。这意味着:

- 深度推理:未来的模型在写下第一行代码之前,可能会花费数秒甚至数分钟进行**“思维链”**的推演。它们会在内部模拟不同的架构方案,权衡利弊,甚至在脑海中预运行代码以检查逻辑漏洞。

- 自主规划:目前的Agent在面对长达数天的复杂任务时容易迷失。下一代模型将具备更强的工作记忆和规划能力,能够维持跨越数千个步骤的任务连贯性。这将使得“给我写一个完整的电商后台”从科幻变为可能。

未来的竞争将不再仅仅是模型智商的竞争,而是生态连接性的竞争。Google通过垂直整合其庞大生态(安卓、Chrome、G-Suite、GCP),预计Gemini 3将深度整合这些资源,实现**“原生多模态”和“原生工具调用”**。而Anthropic则通过推出MCP协议,试图建立一个去中心化的联盟,让成千上万的第三方SaaS服务(如Notion、Slack、Jira、Linear)通过MCP标准连接到Claude。

对工程师来说,这意味着未来的编程环境将更加碎片化也更加强大。你需要根据任务的生态属性来选择模型:处理Google文档用Gemini,处理复杂第三方SaaS流用Claude加MCP。

面对Karpathy所描述的“里氏九级地震”,许多工程师感到恐慌,传统的职业路径图似乎被撕碎了。我们该何去何从?以下是基于行业领袖洞察的、具体的行动指南:

态度层面:极度谦逊与极度好奇

- 拥抱“新手心态”:承认自己的无知,无论你是经验丰富的架构师还是刚毕业的学生,在Agentic AI面前,我们都是新手。固守旧经验、拒绝尝试新工具的人,将是第一批被淘汰者。

- 忍受不适感:使用新工具时,挫败感是常态。AI会“犯蠢”,会误解你的意图,甚至改坏代码。不要因此弃用,而应将其视为“磨合期”。了解它的脾气,摸清它的边界,本身就是一种核心竞争力。

技能层面:点亮新的科技树

- 精通MCP(模型上下文协议):不要只做工具的使用者,要做工具的连接者。学习如何编写简单的MCP服务器,将你公司的内部API、数据库暴露给AI。你将成为不可替代的“翻译官”,连接两个世界的桥梁。

- 成为语境架构师(Context Architect):练习**“为AI而写”**的文档编写能力。学会用自然语言清晰、无歧义地描述复杂逻辑。同时,建立个人的“Prompt/Context库”,像珍藏代码片段一样珍藏高效指令模式。

- 重拾基础:Linux与Bash:随着AI越来越多地通过命令行操作世界,熟练掌握

Linux和Bash将让你更好地理解、监控和纠正AI的行为。CLI是人机共用的通用语言。

职业定位:向价值链两端移动

随着代码生成的边际成本趋近于零,“纯粹的代码实现”价值将大幅缩水。工程师的价值将向价值链的两端挤压:

- 上游:产品定义与系统设计。决定“做什么”比“怎么做”更重要。你需要更懂业务、更懂用户、更懂宏观架构。

- 下游:质量保证与系统运维。确保“做出来的东西能用、安全、稳定”。你需要更懂测试、更懂安全、更懂运维监控。

中间那个“把明确的需求翻译成Java代码”的环节,将由AI代理接管。

人类的底色:练习“无AI”编程

Addy Osmani提出了一个极其重要的建议:定期进行“无AI挑战”。就像飞行员虽然大部分时间使用自动驾驶,但必须定期在模拟器中练习手动飞行和处置特情一样,工程师也需要保持对底层原理的**“肌肉记忆”**。

- 不要让大脑萎缩:如果你连基础的循环逻辑都需要问AI,你就丧失了验证AI代码的能力,将沦为“感觉编程”的奴隶。

- 深度工作的价值:在某些时刻,关掉Copilot,关掉Claude,独自面对空白的编辑器思考。这种深度的、无辅助的脑力活动,是产生真正创新思想的源泉。

卡帕西的焦虑是真实的,它标志着一个时代的结束。那个仅仅依靠记忆语法、精通API调用、做一个“熟练的打字员”就能获得高薪的“美好旧时光”,已经一去不复返了。

然而,这并非职业的终结,而是职业的升维。正如卡帕西所言,只要能正确串联起这些工具,你就能拥有**“十倍的力量”**。我们不再是孤独的工匠,我们是第一批接触外星科技的探索者,是驾驭数字风暴的魔法师,是指挥硅基智能军团的将军。

地震虽然摧毁了旧的建筑,但也暴露出了深埋地下的富矿。现在,是时候拿起新的镐头——Agent、MCP、Context——去开采属于AI时代的宝藏了。

不要惊慌。卷起袖子。欢迎来到新世界。

|  |  |